最終更新日:2023/12/20

現在多くの企業・組織が、データ分析や予測モデル構築のために機械学習を導入し始めています。

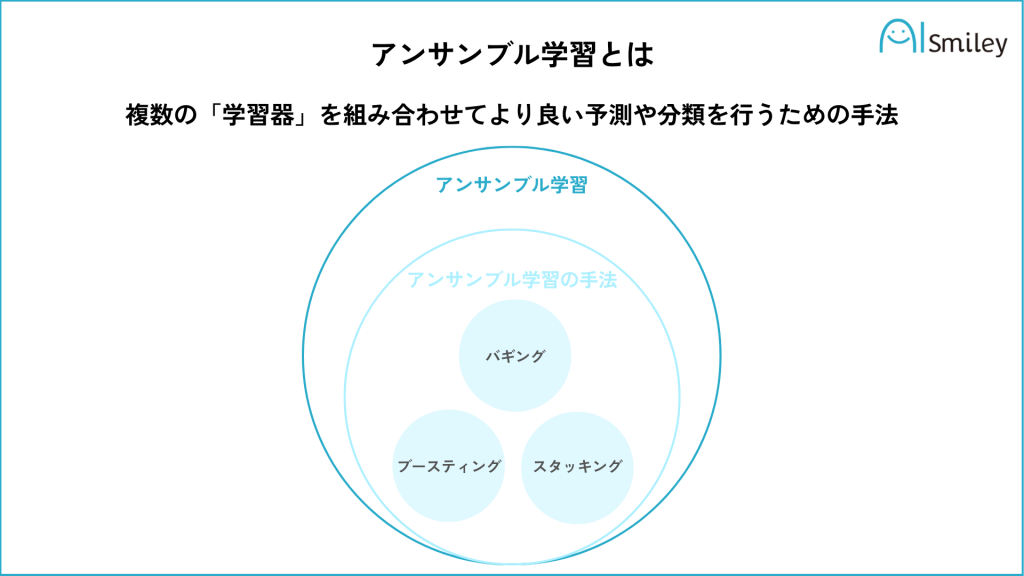

その一方で、単一の機械学習モデルでは十分な予測精度を達成することは難しく、アンサンブル学習が注目を集めています。機械学習におけるアンサンブル学習とは、複数の学習モデルを組み合わせて、より精度の高いモデルを構築する手法です。

アンサンブル学習の代表的な手法には、バギングやブースティング、スタッキングなどがあります。ここでは、アンサンブル学習の基本的な考え方や種類、実用例、メリットとデメリットについて解説します。

機械学習について詳しく知りたい方は以下の記事もご覧ください。

機械学習とは?種類や仕組み、活用事例をわかりやすく簡単に説明

アンサンブル学習とは?

アンサンブル学習とは、複数の機械学習モデルを組み合わせて、より高い精度の回答を得る手法です。

アンサンブルとは、音楽用語の「アンサンブル(ensemble)」に由来し、二人以上で協力して歌唱または演奏することを指します。調和を意味する名詞で、複数のものが集まり一つになるという意味もあります。

つまり、単一の機械学習モデルでは十分な精度を達成できない場合に、アンサンブル学習を用いることで、より正確な予測を得ることができます。

バイアスとバリアンスのバランスがアンサンブル学習の鍵

アンサンブル学習は、複数の学習モデルを組み合わせることで、より優れた予測精度を実現する手法です。

その鍵となるのが、「バイアス」と「バリアンス」のバランスです。

バイアス(Bias):

バイアスは、予測が実際の値からどれくらいズレているかを表す指標です。つまり、バイアスが大きいと、予測が実際の値から遠く離れてしまっているということです。

バリアンス(Variance):

バリアンスは、予測がどれくらい変動するかを示す指標です。つまり、バリアンスが大きいと、予測が一貫性がなく、安定していないということです。

バイアスとバリアンスのバランスは以下のように考えることができます。

| バリアンスが低い | バリアンスが高い | |

| バイアスが高い | モデルはデータの構造を十分に学習していないため、予測精度が低い(過小適合)。 | この領域では、モデルはデータの構造をあまり学習せず、さらに予測結果が不安定である。 |

| バイアスが低い | この領域では、モデルはデータの構造を適切に学習し、予測結果も安定している。これが最も理想的な状態。 | この領域では、モデルはデータの構造を過剰に学習し(過学習)、新しいデータに対する予測結果が不安定となる。 |

アンサンブル学習では、バイアスとバリアンスのバランスを適切に調整し、「バイアスもバリアンスも低い」状態を目指します。

適切なバイアスとバリアンスのバランスを取ることで、過学習や過小適合を防ぎ、汎化性能の高いモデルを構築することが可能となります。

アンサンブル学習の種類

アンサンブル学習には様々な手法があります。それぞれの手法には特徴があり、どの手法を選ぶかによって精度が大きく変わってきます。

今回はバギング・ブースティング・スタッキングについて紹介します。

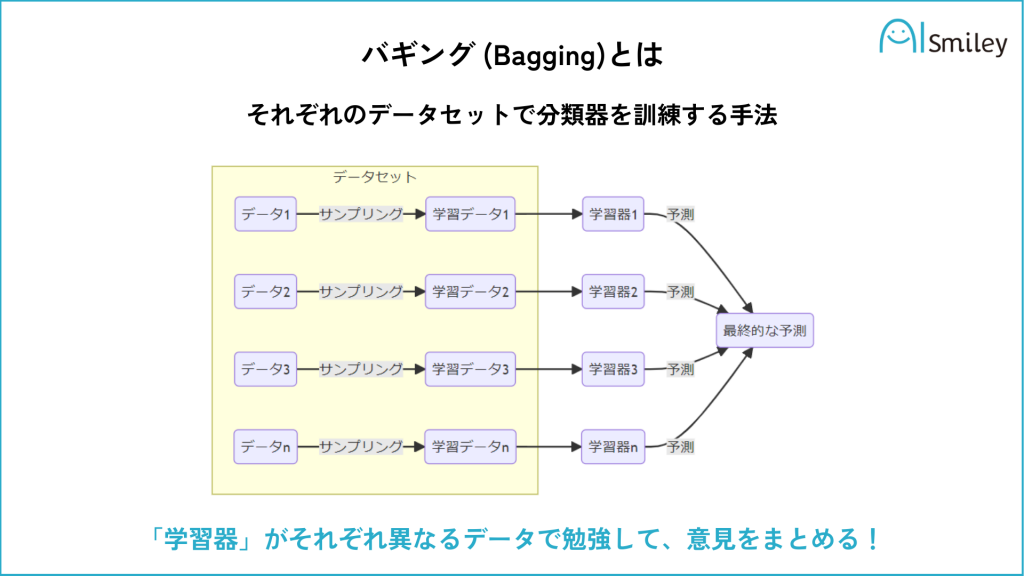

バギング(Bagging)

バギングとは「Bootstrap AGGregatING(ブートストラップ集約法)」の略です。ブートストラップとは、ランダムな標本を抽出することにより標本分布を推定する統計手法です。

ランダムに複数の学習データを選び、そのデータを使って学習器を作成します。そこで得た結果を全て集め、最終決定をおこないます。数値を予測する「回帰」の場合は平均値を、属するクラスを予測する「分類」の場合は多数決を採用します。

バギングは実装が難しくなく、精度も高いためアンサンブル学習の中でもよく利用されています。

ランダムフォレスト(Random Forest)とは?

バギングを応用したアルゴリズムの例として「ランダムフォレスト」が挙げられます。

ランダムフォレストとは、「決定木」と「アンサンブル学習(バギング)」の2つの手法を組み合わせたアルゴリズムです。

「決定木」とは、「予測」「判別」「分類」といった目的で用いられる手法で、Yes/Noなど二者択一の質問を階層構造的につなげ、1つずつ答えていくことで最終的に正解にたどり着ける仕組みです。

ランダムフォレストについて詳しく知りたい方は以下の記事もご覧ください。

ランダムフォレストとは?基本の仕組みから活用事例までまとめて解説

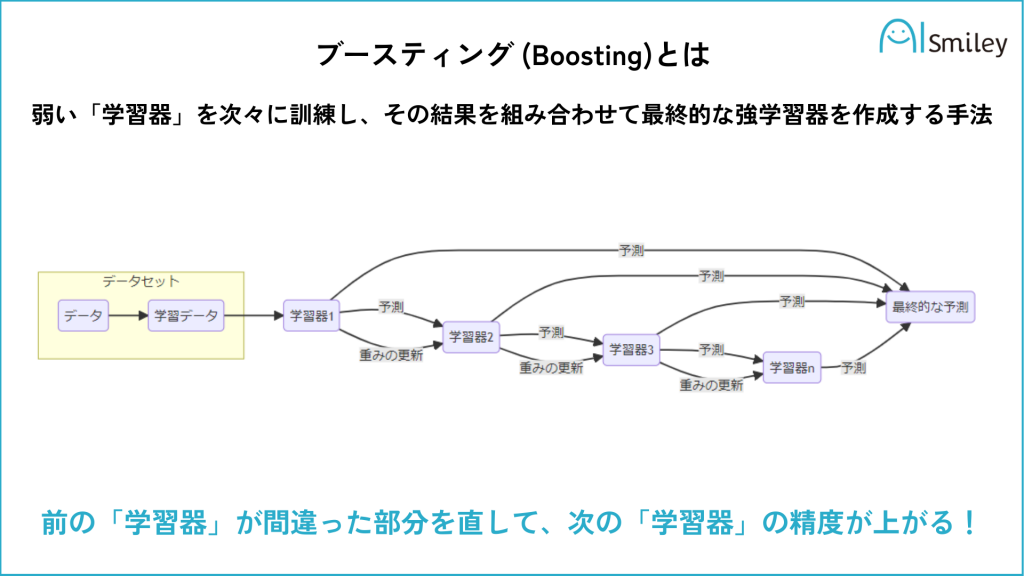

ブースティング (Boosting)

ブースティングは、直訳すると「増強する」という意味です。

ブースティングは過去の学習の誤差・誤りに注目し、その誤差を修正することで、精度の向上を図ります。弱い学習器を重ね合わせることで、誤分類のデータに対して重みをつけて学習を進めることができ、精度の高いモデルを構築することができます。

ブースティングにはいくつかの手法がありますが、その中でも代表的なのがAdaBoost(Adaptive Boosting)です。

また、ブースティングは、バギングと比較して精度が高いとされていますが、過学習に注意が必要です。過学習になると、学習時に利用したデータに過剰に適合し、汎用性がなくなってしまいます。

また計算量が多く、処理に時間がかかります。しかし、特徴量の選択や前処理が十分でない場合にも、精度の向上が見込めるため、実務でもよく使われる手法の一つです。

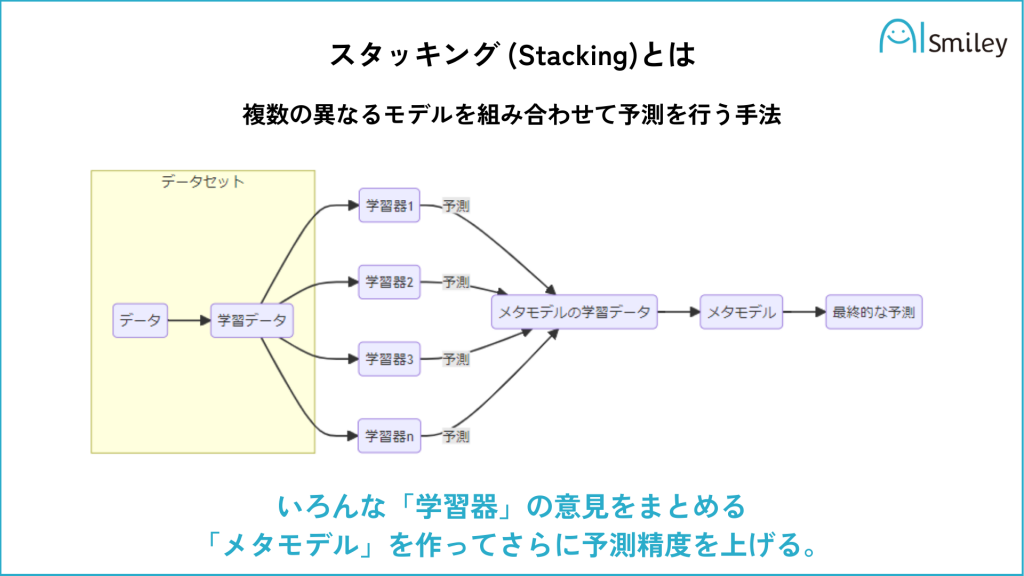

スタッキング (Stacking)

スタッキングは、直訳すると「積み重ねる」という意味です。

二段階以上の学習をし、新たな予測モデルを構築する手法です。

第一段階では、ランダムフォレストやブースティングなどを様々な計算法を使って、できるだけ多くのモデルを用意します。そして第二段階では、第一段階で得たデータをもとに最終的に一つの学習器を作成します。データによっては第三段階に移行し、さらに分析を深める場合もあります。

様々な計算方法(アルゴリズム)を使った結果を使用できるため、精度が高くなる傾向にありますが、データを積み上げるため時間がかかります。

アンサンブル学習のメリット

アンサンブル学習のメリットとして、以下が挙げられます。

精度向上

複数のモデルを組み合わせることで、個別のモデルよりも高い予測精度を実現できます。それぞれのモデルが捉えた異なる特徴を利用し、予測結果を組み合わせることで、より正確な予測が可能です。

汎用性向上

異なるモデルを組み合わせることで、様々なデータに対応可能な汎用性の高いモデルを構築できます。

アンサンブル学習のデメリット

アンサンブル学習のデメリットとして、以下が挙げられます。

計算コストの増加

アンサンブル学習は複数のモデルを組み合わせるため、個別のモデルを使用するよりも多くの計算コストが必要になります。組み合わせるモデルが増えれば増えるほど、計算コストが高くなります。

過学習の可能性

訓練データが偏った場合に、過学習となるリスクがあります。過学習になると、学習時に利用したデータに過剰に適合し、正しい判断ができなくなってしまうため、対策が必要です。

過学習について詳しく知りたい方は以下の記事もご覧ください。

過学習とは?具体例と起きる要因から避けるための対策までご紹介

解釈性の低下

複数のモデルを組み合わせることで、モデルの解釈性が低下する場合があります。

解釈性とは、モデルやアルゴリズムがどのように結論を導き出したかを理解しやすく説明できる性質のことです。つまり、モデルやアルゴリズムが出した結果を、人間が理解しやすく説明できるかどうかを示す指標と言えます。

解釈性が高いモデルやアルゴリズムは、その結果をもとに適切な判断や行動をすることができます。一方で、解釈性が低いモデルやアルゴリズムは、その結果を信じることができず、不適切な判断や行動を招く可能性があります。

つまり、アンサンブル学習によって複数のモデルが組み合わさると、各モデルが何を根拠にどう予測したのかを理解することが難しくなる可能性があります。

アンサンブル学習の使用例

金融分野における予測モデル

アンサンブル学習は、株価や為替レートの予測モデルにも使われます。金融市場は複雑な動きをするため、単一のモデルでは十分な精度を出すことが難しく、アンサンブル学習が適しているとされています。

医療分野における疾患予測

アンサンブル学習は、医療分野においても活用されています。複数のモデルを組み合わせることで、患者ごとの疾患の予測精度を向上させることができます。

まとめ

今回はアンサンブル学習について紹介しました。

複数の機械学習モデルを組み合わせるアンサンブル学習をサービスに活用すれば、今後の生活もますます便利になるでしょう。

AIsmileyでは、AI導入に詳しいコンサルタントが無料で相談に乗っています。AI導入についてお悩みの方は、ぜひ一度ご相談ください。

担当者へのお問い合わせ | AI製品・サービスの比較・検索・資料請求サイト

AIについて詳しく知りたい方は以下の記事もご覧ください。

AI・人工知能とは?定義・歴史・種類・仕組みから事例まで徹底解説

よくある質問

アンサンブル学習とは?

アンサンブル学習とは、複数の機械学習モデルを組み合わせて、より高い精度の回答を得る手法です。

アンサンブル学習の種類には何がある?

アンサンブル学習の種類の例として、以下が挙げられます。

- バギング

- ブースティング

- スタッキング

アンサンブル学習のメリットは?

アンサンブル学習のメリットとして、以下が挙げられます。

- 精度向上

- 汎用性向上

からの記事と詳細 ( アンサンブル学習とは?スタッキングやブースティングの手法も解説 | DXを推進するAIポータルメディア「AIsmiley」 - AIsmiley )

https://ift.tt/BoUlVNr

No comments:

Post a Comment